Lifekeeper for Linux 이중화 설정 – 복제볼륨 (Disk replication) 설정1 포스팅에 이어서 진행합니다.

2022.09.18 - [IT/lifekeeper] - Lifekeeper for Linux 이중화 설정 – 복제볼륨 (Disk replication) 설정1

Lifekeeper for Linux 이중화 설정 – 복제볼륨 (Disk replication) 설정1

Active – Standby 구조로 이중화된 시스템에서 Active 서버에서 장애가 발생할 경우 Standby 서버에서는 장애발생 직전 최종 데이터로 DB 또는 애플리케이션을 기동해야 합니다. 이를 위해 일반적으로

justdaily.tistory.com

이 포스팅은 아래의 버전에서 테스트한 내용을 기반으로 작성하였습니다

Linux : Red Hat Enterprise Linux release 8.5

Lifekeeper : LifeKeeper for Linux 9.6.1

1. Lifekeeper 복제볼륨 리소스 설정 - Extend

전 단계까지 1번 서버의 설정이 완료되면 자동으로 Target Server 설정이 진행됩니다.

2번 서버를 선택 후 Next 버튼을 클릭합니다.

2번 서버의 Switchback Type을 선택합니다.

1번 서버와 동일하게 “intelligent”를 선택 후 Next 버튼을 클릭합니다.

생성할 복제 볼륨 리소스의 Priority를 설정하는 단계입니다.

Priority는 낮은 값이 우선순위가 높으며 failover 발생 시 우선순위가 높은 서버로 failover를 진행합니다.

2 node의 이중화 구성에서는 failover 상황 발생시 failover 진행 가능 서버는 1대뿐이므로 Priority의 의미가 사실상 없으며 3 node이상 구성부터 의미가 있는 설정 값입니다.

Template Priority는 “1” 로 지정하고 Next 버튼을 클릭합니다.

Target Priority는 “10” 으로 지정하고 Next 버튼을 클릭합니다.

Target서버(2번 서버)로 리소스 설정이 가능한지 확인하는 단계입니다.

체크 성공 메시지를 확인 후 Next 버튼을 클릭합니다.

Target서버의 Mount point를 설정하는 단계입니다.

1번 서버 설정 단계에서 입력한 Mount point가 자동으로 입력되므로 확인 후 Next 버튼을 클릭합니다.

Target서버의 Filesystem tag 설정 단계입니다.

1번 서버의 설정 값이 자동으로 입력되므로 확인 후 Next버튼을 클릭합니다.

Target Disk를 선택하는 단계입니다.

1번 서버의 Source 볼륨과 동기화할 Disk를 선택하고 Next 버튼을 클릭합니다.

Target서버의 Replication Resource의 Tag를 설정하는 단계입니다.

1번 서버에 설정한 값이 자동으로 입력되므로 확인 후 Next 버튼을 클릭합니다.

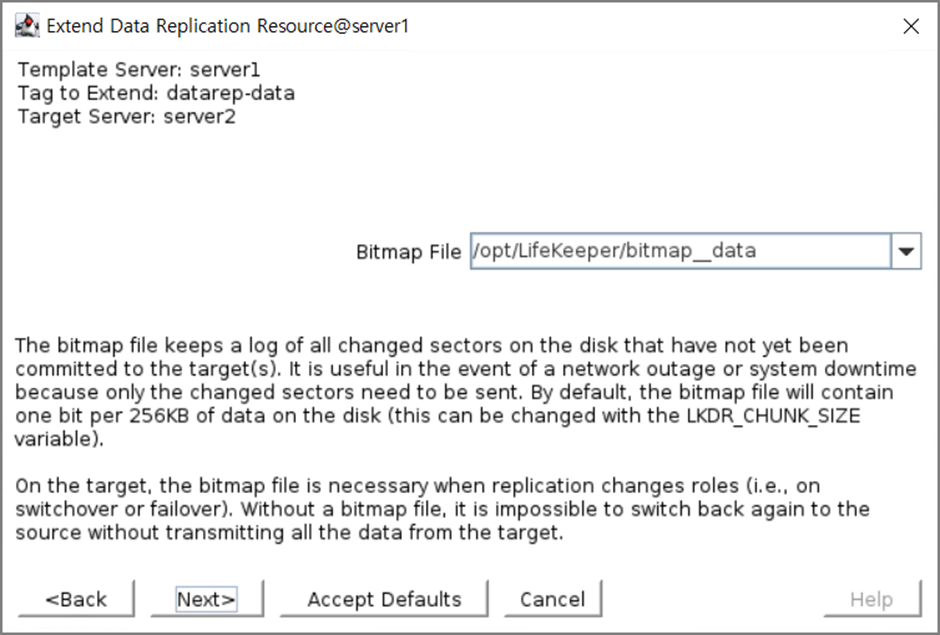

Target서버의 Bitmap File 생성 위치를 지정하는 단계입니다.

1번 서버에 설정한 값이 자동으로 입력되므로 확인 후 Next 버튼을 클릭합니다.

동기화 트래픽을 전송할 Replication Path를 지정합니다.

Service 트래픽과 분리될 수 있도록 Service대역이 아닌 대역을 선택합니다.

Target서버의 복제 볼륨 리소스 설정이 완료되었습니다.

2 node 구성에서는 더 이상 설정할 서버가 없으므로 Finish 버튼을 클릭하여 설정 작업을 종료합니다.

Done 버튼을 클릭하여 설정을 완료합니다.

Lifekeeper GUI에 생성된 복제볼륨 정보가 표시됩니다.

1번 서버 : Active , 2번 서버 : Standby

Linux CLI 입력창에서 클러스터 정보를 확인하는 “lcdstatus -q” 를 수행하여 동일한 정보를 확인할 수 있습니다.

1번 서버 STATE : ISP

2번 서버 STATE : OSU

ISP는 Active , OSU는 Standby의 의미를 갖습니다.

“lcdstatus” 의 자세한 사용법과 표시정보는 차후 별도로 다루도록 하겠습니다

생성한 복제 볼륨 리소스는 Active 서버에만 mount 되며, Standby 서버는 umount 상태에서 동작합니다.

Active 상태인 1번 서버에서 /dev/md0 디바이스 가 /data 로 mount 됨

Standby 상태인 2번 서버에서 /data 는 umount 상태

지금까지의 과정으로 Lifekeeper에서 복제 볼륨 리소스를 설정하는 방법에 대해 알아봤습니다.

다음 포스팅에서는 Lifekeeper GUI 환경에서 Postgresql DB 리소스 설정 방법을 알아보도록 하겠습니다.

감사합니다.

'IT > lifekeeper' 카테고리의 다른 글

| Lifekeeper for Linux postgresql DB 이중화 구성하기2 (0) | 2022.09.21 |

|---|---|

| Lifekeeper for Linux postgresql DB 이중화 구성하기1 (0) | 2022.09.20 |

| Lifekeeper for Linux 이중화 설정 – 복제볼륨 (Disk replication) 설정1 (0) | 2022.09.18 |

| Lifekeeper for Linux 이중화 설정 – VIP 설정2 (0) | 2022.09.17 |

| Lifekeeper for Linux 이중화 설정 – VIP 설정1 (0) | 2022.09.17 |

댓글